什么是大型语言模型 (LLM)?

大型语言模型定义

大型语言模型 (LLM) 是一种深度学习算法,可以执行各种自然语言处理 (NLP)任务。大型语言模型使用 Transformer 模型,并使用海量数据集进行训练,因此称为“大型”。这使它们能够识别、翻译、预测或生成文本或其他内容。

大型语言模型也称为 神经网络 (NN),这是一种受人脑启发的计算系统。这些神经网络使用分层的节点网络工作,非常像神经元。

除了教授人工智能 (AI) 应用人类语言外,大型语言模型还可以经过训练来执行各种任务,例如理解蛋白质结构、编写软件代码等等。与人脑一样,大型语言模型必须经过预训练,然后进行微调,以便它们能够解决文本分类、问题解答、文档摘要和文本生成问题。它们的问题解决能力可以应用于医疗保健、金融和娱乐等领域,在这些领域,大型语言模型提供各种 NLP 应用,例如翻译、聊天机器人、AI 助手等等。

大型语言模型还具有大量的参数,这些参数类似于模型在从训练中学习时收集的记忆。可以将这些参数视为模型的知识库。

观看此视频,更深入地了解 LLM。

那么,什么是 Transformer 模型?

Transformer 模型是大型语言模型最常见的架构。它由编码器和解码器组成。Transformer 模型通过标记化输入来处理数据,然后同时进行数学运算以发现标记之间的关系。这使计算机能够看到人类在收到相同查询时会看到的模式。

Transformer 模型使用自注意力机制,这使该模型能够比长短期记忆模型等传统模型更快地学习。自注意力使 Transformer 模型能够考虑序列的不同部分,或句子的整个上下文,来生成预测。

大型语言模型的关键组件

大型语言模型由多个神经网络层组成。循环层、前馈层、嵌入层和注意力层协同工作来处理输入文本并生成输出内容。

嵌入层从输入文本创建嵌入。大型语言模型的这一部分捕获输入的语义和句法含义,以便模型可以理解上下文。

大型语言模型的前馈层 (FFN) 由多个完全连接的层组成,这些层转换输入嵌入。这样,这些层使模型能够收集更高层次的抽象,也就是说,理解用户对文本输入的意图。

循环层按顺序解释输入文本中的单词。它捕获句子中单词之间的关系。

注意力机制使语言模型能够专注于与手头任务相关的输入文本的单个部分。这一层允许模型生成最准确的输出。

大型语言模型主要分为三种。

- 通用或原始语言模型 根据训练数据中的语言预测下一个词。这些语言模型执行信息检索任务。

- 指令微调语言模型 经过训练,可以预测对输入中给出的指令的响应。这使它们能够执行情感分析,或生成文本或代码。

- 对话微调语言模型 经过训练,可以通过预测下一个响应来进行对话。可以将其视为聊天机器人或对话式人工智能。

大型语言模型和生成式人工智能之间有什么区别?

生成式人工智能 是一个总称,指的是具有生成内容能力的人工智能模型。生成式人工智能可以生成文本、代码、图像、视频和音乐。生成式人工智能的例子包括 Midjourney、DALL-E 和 ChatGPT。

大型语言模型是一种生成式人工智能,它在文本上进行训练并生成文本内容。ChatGPT 是一个流行的生成文本人工智能的例子。

所有大型语言模型都是生成式人工智能1。

大型语言模型是如何工作的?

大型语言模型基于 Transformer 模型,其工作原理是接收输入,对其进行编码,然后对其进行解码以产生输出预测。但是,在大型语言模型可以接收文本输入并生成输出预测之前,它需要进行训练,以便它可以履行一般功能,并进行微调,使其能够执行特定任务。

训练: 大型语言模型使用来自 Wikipedia、GitHub 等网站的大型文本数据集进行预训练。这些数据集由数万亿个单词组成,其质量会影响语言模型的性能。在这个阶段,大型语言模型进行无监督学习,这意味着它处理提供给它的数据集,而无需特定指令。在此过程中,LLM 的人工智能算法可以学习单词的含义以及单词之间的关系。它还可以学习根据上下文区分单词。例如,它会学习理解“right”是指“正确”,还是指“左”的反义词。

微调: 为了让大型语言模型执行特定任务(例如翻译),必须针对该特定活动对其进行微调。微调可以优化特定任务的性能。

提示微调 的功能与微调类似,它通过少样本提示或零样本提示来训练模型执行特定任务。提示是给 LLM 的指令。少样本提示通过使用示例来教模型预测输出。例如,在这个情感分析练习中,少样本提示如下所示

Customer review: This plant is so beautiful!

Customer sentiment: positive

Customer review: This plant is so hideous!

Customer sentiment: negative

语言模型将通过“hideous”的语义含义以及因为提供了相反的示例,理解第二个示例中的客户情绪为“负面”。

或者,零样本提示不使用示例来教语言模型如何响应输入。相反,它将问题形式化为“‘This plant is so hideous’ 的情绪是…”。它清楚地指出了语言模型应该执行的任务,但没有提供解决问题的示例。

大型语言模型的用例

大型语言模型可以用于多种目的

- 信息检索: 想想必应或谷歌。每当您使用它们的搜索功能时,您都在依赖大型语言模型来生成响应查询的信息。它能够检索信息,然后以对话的方式总结和传达答案。

- 情感分析: 作为 自然语言处理的应用,大型语言模型使公司能够分析文本数据的情感。

- 文本生成: 大型语言模型是 ChatGPT 等生成式人工智能的幕后推手,可以根据输入生成文本。它们可以在提示时生成文本示例。例如:“用艾米莉·狄金森的风格写一首关于棕榈树的诗。”

- 代码生成: 与文本生成类似,代码生成是生成式人工智能的应用。LLM 理解模式,这使它们能够生成代码。

- 聊天机器人和对话式人工智能: 大型语言模型使客户服务聊天机器人或对话式人工智能能够与客户互动,解释其查询或响应的含义,并反过来提供响应。

除了这些用例之外,大型语言模型还可以完成句子、回答问题和总结文本。

凭借如此广泛的应用,大型语言应用程序可以在多个领域找到。

- 科技: 大型语言模型的应用范围很广,从使搜索引擎能够响应查询,到帮助开发人员编写代码。

- 医疗保健和科学: 大型语言模型能够理解蛋白质、分子、DNA 和 RNA。这种能力使 LLM 能够协助开发疫苗、寻找疾病的治疗方法以及改进预防性医疗药物。LLM 还被用作医疗聊天机器人,以执行患者入院或基本诊断。

- 客户服务: LLM 被各行各业用于客户服务目的,例如聊天机器人或对话式人工智能。

- 营销: 营销团队可以使用 LLM 执行情感分析,以快速生成广告活动创意或文本作为宣传示例等等。

- 法律: 从搜索大量文本数据集到生成法律术语,大型语言模型可以为律师、律师助理和法律人员提供帮助。

- 银行业: LLM 可以支持信用卡公司检测欺诈行为。

开始在企业中使用生成式人工智能。观看此网络研讨会,了解企业环境中生成式人工智能的挑战和机遇。

大型语言模型的好处

凭借广泛的应用,大型语言模型对于解决问题非常有益,因为它们以清晰、对话的方式提供信息,用户很容易理解。

大量应用: 它们可以用于语言翻译、句子补全、情感分析、问题回答、数学方程式等。

不断改进: 大型语言模型的性能不断提高,因为它在添加更多数据和参数时会不断增长。换句话说,它学得越多,它就越好。更重要的是,大型语言模型可以展现所谓的“上下文学习”。一旦 LLM 经过预训练,少样本提示就能使模型从提示中学习,而无需任何额外的参数。通过这种方式,它在不断学习。

它们学习速度快: 在演示上下文学习时,大型语言模型学习速度快,因为它们不需要额外的权重、资源和参数进行训练。它的速度很快,因为它不需要太多示例。

LLM 的局限性和挑战

大型语言模型可能会给我们一种它们理解含义并能准确响应的印象。但是,它们仍然是一种技术工具,因此,大型语言模型面临着各种各样的挑战。

幻觉: 幻觉是指 LLM 产生错误或与用户意图不符的输出。例如,声称自己是人类,有情绪,或者爱上了用户。由于大型语言模型预测下一个语法正确的单词或短语,它们无法完全解释人类的含义。结果有时可能被称为“幻觉”。

安全性: 如果没有得到适当的管理或监控,大型语言模型会带来重要的安全风险。它们可能会泄露人们的私人信息,参与网络钓鱼诈骗,并产生垃圾邮件。心怀恶意的使用者可以将其意识形态或偏见重新编程到人工智能中,并助长虚假信息的传播。其影响可能是全球性的灾难性后果。

偏见: 用于训练语言模型的数据将影响给定模型产生的输出。因此,如果数据代表单一人口统计数据或缺乏多样性,则大型语言模型产生的输出也将缺乏多样性。

同意: 大型语言模型是在数万亿的数据集上进行训练的,其中一些数据集可能不是在获得同意的情况下获得的。在从互联网抓取数据时,大型语言模型已知会忽略版权许可、抄袭书面内容,并在未经原始所有者或艺术家许可的情况下重复使用专有内容。当它产生结果时,无法跟踪数据来源,而且通常不会给创建者任何功劳,这可能会使用户面临侵犯版权的问题。

它们还可能抓取个人数据,例如照片描述中的主题或摄影师的姓名,这可能会泄露隐私。2 LLM 已经卷入了诉讼,其中包括 Getty Images3 的一项突出诉讼,原因是侵犯了知识产权。

扩展: 扩展和维护大型语言模型可能既困难又耗时且耗费资源。

部署: 部署大型语言模型需要深度学习、Transformer 模型、分布式软件和硬件以及整体技术专业知识。

流行的几种大型语言模型示例

流行的大型语言模型已经风靡全球。许多已被各行各业的人们采用。您无疑听说过 ChatGPT,它是一种生成式人工智能聊天机器人。

其他流行的 LLM 模型包括

- PaLM: 谷歌的 Pathways 语言模型 (PaLM) 是一种 Transformer 语言模型,能够进行常识和算术推理、笑话解释、代码生成和翻译。

- BERT: 来自 Transformer 的双向编码器表示 (BERT) 语言模型也是在谷歌开发的。它是一种基于 Transformer 的模型,可以理解自然语言并回答问题。

- XLNet: XLNet 是一种排列语言模型,以随机顺序生成输出预测,这使其与 BERT 不同。它评估编码的标记的模式,然后以随机顺序而不是顺序预测标记。

- GPT: 生成式预训练 Transformer 可能是最著名的大型语言模型。GPT 由 OpenAI 开发,是一种流行的基础模型,其编号迭代是对其前代产品的改进(GPT-3、GPT-4 等)。可以对其进行微调以执行特定的下游任务。这方面的例子包括 Salesforce 为 CRM 开发的 EinsteinGPT 和 Bloomberg 为金融开发的 BloombergGPT。

大型语言模型的未来发展

ChatGPT 的出现使大型语言模型走到了前沿,并引发了对未来可能是什么样子的猜测和激烈辩论。

随着大型语言模型不断发展并提高其自然语言处理能力,人们对其发展将对就业市场产生的影响感到担忧。 很明显,大型语言模型将具备在某些领域取代工人的能力。

如果使用得当,大型语言模型可以提高生产力和流程效率,但这对其在人类社会中的使用提出了伦理问题。

隆重推出 Elasticsearch 相关性引擎

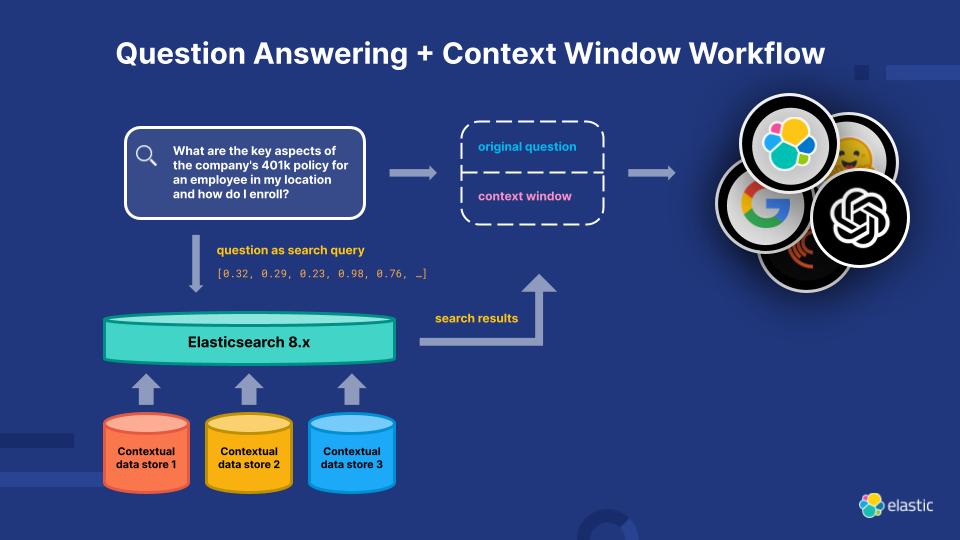

为了解决当前 LLM 的局限性,Elasticsearch 相关性引擎 (ESRE) 是一款专为人工智能驱动的搜索应用程序构建的相关性引擎。借助 ESRE,开发人员可以构建自己的语义搜索应用程序,利用自己的 Transformer 模型,并结合自然语言处理 (NLP)和生成式 AI 来增强客户的搜索体验。

探索更多大型语言模型资源

- Elastic 生成式 AI 工具和功能

- 如何选择向量数据库

- 如何制作聊天机器人:开发人员的注意事项

- 选择 LLM:2024 年开源 LLM 入门指南

- Elasticsearch 中的语言模型

- 2024 年技术趋势:搜索和生成式 AI 如何发展

- Elastic Stack 中自然语言处理 (NLP) 概述

- 与 Elastic Stack 兼容的第三方模型

- Elastic Stack 中已训练模型指南

- LLM 安全评估

脚注

1 Myer, Mike. “生成式 AI 和大型语言模型是一回事吗?” Quiq, 2023 年 5 月 12 日,quiq.com/blog/generative-ai-vs-large-language-models/。

2 Sheng, Ellen. “在生成式 AI 法律乱象中,法庭之战才刚刚开始,”CNBC,2023 年 4 月 3 日,https://www.cnbc.com/2023/04/03/in-generative-ai-legal-wild-west-lawsuits-are-just-getting-started.html (访问时间:2023 年 6 月 29 日)

3 Getty Images 声明,Getty Images,2023 年 1 月 17 日 https://newsroom.gettyimages.com/en/getty-images/getty-images-statement (访问时间:2023 年 6 月 29 日)