- Elasticsearch 指南其他版本

- 8.17 中的新功能

- Elasticsearch 基础

- 快速入门

- 设置 Elasticsearch

- 升级 Elasticsearch

- 索引模块

- 映射

- 文本分析

- 索引模板

- 数据流

- 摄取管道

- 别名

- 搜索您的数据

- 重新排名

- 查询 DSL

- 聚合

- 地理空间分析

- 连接器

- EQL

- ES|QL

- SQL

- 脚本

- 数据管理

- 自动缩放

- 监视集群

- 汇总或转换数据

- 设置高可用性集群

- 快照和还原

- 保护 Elastic Stack 的安全

- Watcher

- 命令行工具

- elasticsearch-certgen

- elasticsearch-certutil

- elasticsearch-create-enrollment-token

- elasticsearch-croneval

- elasticsearch-keystore

- elasticsearch-node

- elasticsearch-reconfigure-node

- elasticsearch-reset-password

- elasticsearch-saml-metadata

- elasticsearch-service-tokens

- elasticsearch-setup-passwords

- elasticsearch-shard

- elasticsearch-syskeygen

- elasticsearch-users

- 优化

- 故障排除

- 修复常见的集群问题

- 诊断未分配的分片

- 向系统中添加丢失的层

- 允许 Elasticsearch 在系统中分配数据

- 允许 Elasticsearch 分配索引

- 索引将索引分配过滤器与数据层节点角色混合,以在数据层之间移动

- 没有足够的节点来分配所有分片副本

- 单个节点上索引的分片总数已超过

- 每个节点的分片总数已达到

- 故障排除损坏

- 修复磁盘空间不足的数据节点

- 修复磁盘空间不足的主节点

- 修复磁盘空间不足的其他角色节点

- 启动索引生命周期管理

- 启动快照生命周期管理

- 从快照恢复

- 故障排除损坏的存储库

- 解决重复的快照策略失败问题

- 故障排除不稳定的集群

- 故障排除发现

- 故障排除监控

- 故障排除转换

- 故障排除 Watcher

- 故障排除搜索

- 故障排除分片容量健康问题

- 故障排除不平衡的集群

- 捕获诊断信息

- REST API

- API 约定

- 通用选项

- REST API 兼容性

- 自动缩放 API

- 行为分析 API

- 紧凑和对齐文本 (CAT) API

- 集群 API

- 跨集群复制 API

- 连接器 API

- 数据流 API

- 文档 API

- 丰富 API

- EQL API

- ES|QL API

- 功能 API

- Fleet API

- 图表探索 API

- 索引 API

- 别名是否存在

- 别名

- 分析

- 分析索引磁盘使用量

- 清除缓存

- 克隆索引

- 关闭索引

- 创建索引

- 创建或更新别名

- 创建或更新组件模板

- 创建或更新索引模板

- 创建或更新索引模板(旧版)

- 删除组件模板

- 删除悬挂索引

- 删除别名

- 删除索引

- 删除索引模板

- 删除索引模板(旧版)

- 存在

- 字段使用情况统计信息

- 刷新

- 强制合并

- 获取别名

- 获取组件模板

- 获取字段映射

- 获取索引

- 获取索引设置

- 获取索引模板

- 获取索引模板(旧版)

- 获取映射

- 导入悬挂索引

- 索引恢复

- 索引段

- 索引分片存储

- 索引统计信息

- 索引模板是否存在(旧版)

- 列出悬挂索引

- 打开索引

- 刷新

- 解析索引

- 解析集群

- 翻转

- 收缩索引

- 模拟索引

- 模拟模板

- 拆分索引

- 解冻索引

- 更新索引设置

- 更新映射

- 索引生命周期管理 API

- 推理 API

- 信息 API

- 摄取 API

- 许可 API

- Logstash API

- 机器学习 API

- 机器学习异常检测 API

- 机器学习数据帧分析 API

- 机器学习训练模型 API

- 迁移 API

- 节点生命周期 API

- 查询规则 API

- 重新加载搜索分析器 API

- 存储库计量 API

- 汇总 API

- 根 API

- 脚本 API

- 搜索 API

- 搜索应用程序 API

- 可搜索快照 API

- 安全 API

- 身份验证

- 更改密码

- 清除缓存

- 清除角色缓存

- 清除权限缓存

- 清除 API 密钥缓存

- 清除服务帐户令牌缓存

- 创建 API 密钥

- 创建或更新应用程序权限

- 创建或更新角色映射

- 创建或更新角色

- 批量创建或更新角色 API

- 批量删除角色 API

- 创建或更新用户

- 创建服务帐户令牌

- 委托 PKI 身份验证

- 删除应用程序权限

- 删除角色映射

- 删除角色

- 删除服务帐户令牌

- 删除用户

- 禁用用户

- 启用用户

- 注册 Kibana

- 注册节点

- 获取 API 密钥信息

- 获取应用程序权限

- 获取内置权限

- 获取角色映射

- 获取角色

- 查询角色

- 获取服务帐户

- 获取服务帐户凭据

- 获取安全设置

- 获取令牌

- 获取用户权限

- 获取用户

- 授予 API 密钥

- 具有权限

- 使 API 密钥失效

- 使令牌失效

- OpenID Connect 准备身份验证

- OpenID Connect 身份验证

- OpenID Connect 注销

- 查询 API 密钥信息

- 查询用户

- 更新 API 密钥

- 更新安全设置

- 批量更新 API 密钥

- SAML 准备身份验证

- SAML 身份验证

- SAML 注销

- SAML 失效

- SAML 完成注销

- SAML 服务提供商元数据

- SSL 证书

- 激活用户配置文件

- 禁用用户配置文件

- 启用用户配置文件

- 获取用户配置文件

- 建议用户配置文件

- 更新用户配置文件数据

- 具有用户配置文件权限

- 创建跨集群 API 密钥

- 更新跨集群 API 密钥

- 快照和还原 API

- 快照生命周期管理 API

- SQL API

- 同义词 API

- 文本结构 API

- 转换 API

- 使用情况 API

- Watcher API

- 定义

- 迁移指南

- 发行说明

- Elasticsearch 版本 8.17.0

- Elasticsearch 版本 8.16.1

- Elasticsearch 版本 8.16.0

- Elasticsearch 版本 8.15.5

- Elasticsearch 版本 8.15.4

- Elasticsearch 版本 8.15.3

- Elasticsearch 版本 8.15.2

- Elasticsearch 版本 8.15.1

- Elasticsearch 版本 8.15.0

- Elasticsearch 版本 8.14.3

- Elasticsearch 版本 8.14.2

- Elasticsearch 版本 8.14.1

- Elasticsearch 版本 8.14.0

- Elasticsearch 版本 8.13.4

- Elasticsearch 版本 8.13.3

- Elasticsearch 版本 8.13.2

- Elasticsearch 版本 8.13.1

- Elasticsearch 版本 8.13.0

- Elasticsearch 版本 8.12.2

- Elasticsearch 版本 8.12.1

- Elasticsearch 版本 8.12.0

- Elasticsearch 版本 8.11.4

- Elasticsearch 版本 8.11.3

- Elasticsearch 版本 8.11.2

- Elasticsearch 版本 8.11.1

- Elasticsearch 版本 8.11.0

- Elasticsearch 版本 8.10.4

- Elasticsearch 版本 8.10.3

- Elasticsearch 版本 8.10.2

- Elasticsearch 版本 8.10.1

- Elasticsearch 版本 8.10.0

- Elasticsearch 版本 8.9.2

- Elasticsearch 版本 8.9.1

- Elasticsearch 版本 8.9.0

- Elasticsearch 版本 8.8.2

- Elasticsearch 版本 8.8.1

- Elasticsearch 版本 8.8.0

- Elasticsearch 版本 8.7.1

- Elasticsearch 版本 8.7.0

- Elasticsearch 版本 8.6.2

- Elasticsearch 版本 8.6.1

- Elasticsearch 版本 8.6.0

- Elasticsearch 版本 8.5.3

- Elasticsearch 版本 8.5.2

- Elasticsearch 版本 8.5.1

- Elasticsearch 版本 8.5.0

- Elasticsearch 版本 8.4.3

- Elasticsearch 版本 8.4.2

- Elasticsearch 版本 8.4.1

- Elasticsearch 版本 8.4.0

- Elasticsearch 版本 8.3.3

- Elasticsearch 版本 8.3.2

- Elasticsearch 版本 8.3.1

- Elasticsearch 版本 8.3.0

- Elasticsearch 版本 8.2.3

- Elasticsearch 版本 8.2.2

- Elasticsearch 版本 8.2.1

- Elasticsearch 版本 8.2.0

- Elasticsearch 版本 8.1.3

- Elasticsearch 版本 8.1.2

- Elasticsearch 版本 8.1.1

- Elasticsearch 版本 8.1.0

- Elasticsearch 版本 8.0.1

- Elasticsearch 版本 8.0.0

- Elasticsearch 版本 8.0.0-rc2

- Elasticsearch 版本 8.0.0-rc1

- Elasticsearch 版本 8.0.0-beta1

- Elasticsearch 版本 8.0.0-alpha2

- Elasticsearch 版本 8.0.0-alpha1

- 依赖项和版本

示例:解析通用日志格式的日志

编辑示例:解析通用日志格式的日志

编辑在本示例教程中,您将使用 ingest 管道 在索引之前解析 通用日志格式 的服务器日志。开始之前,请查看 ingest 管道的 先决条件。

您要解析的日志类似于以下内容

212.87.37.154 - - [05/May/2099:16:21:15 +0000] "GET /favicon.ico HTTP/1.1" 200 3638 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36"

这些日志包含时间戳、IP 地址和用户代理。您希望在 Elasticsearch 中为这三个项目提供自己的字段,以便更快地进行搜索和可视化。您还想知道请求的来源。

-

在 Kibana 中,打开主菜单,然后单击 Stack Management > Ingest Pipelines。

- 单击 创建管道 > 新管道。

- 将 名称 设置为

my-pipeline,并可选择为管道添加描述。 -

添加一个 grok 处理器 来解析日志消息

- 单击 添加处理器,然后选择 Grok 处理器类型。

-

将 字段 设置为

message,将 模式 设置为以下 grok 模式%{IPORHOST:source.ip} %{USER:user.id} %{USER:user.name} \[%{HTTPDATE:@timestamp}\] "%{WORD:http.request.method} %{DATA:url.original} HTTP/%{NUMBER:http.version}" %{NUMBER:http.response.status_code:int} (?:-|%{NUMBER:http.response.body.bytes:int}) %{QS:http.request.referrer} %{QS:user_agent}

- 单击 添加 以保存处理器。

- 将处理器描述设置为

从 'message' 中提取字段。

-

为时间戳、IP 地址和用户代理字段添加处理器。按如下方式配置处理器

处理器类型 字段 其他选项 描述 @timestamp格式:

dd/MMM/yyyy:HH:mm:ss Z将 '@timestamp' 格式化为 'dd/MMM/yyyy:HH:mm:ss Z'source.ip目标字段:

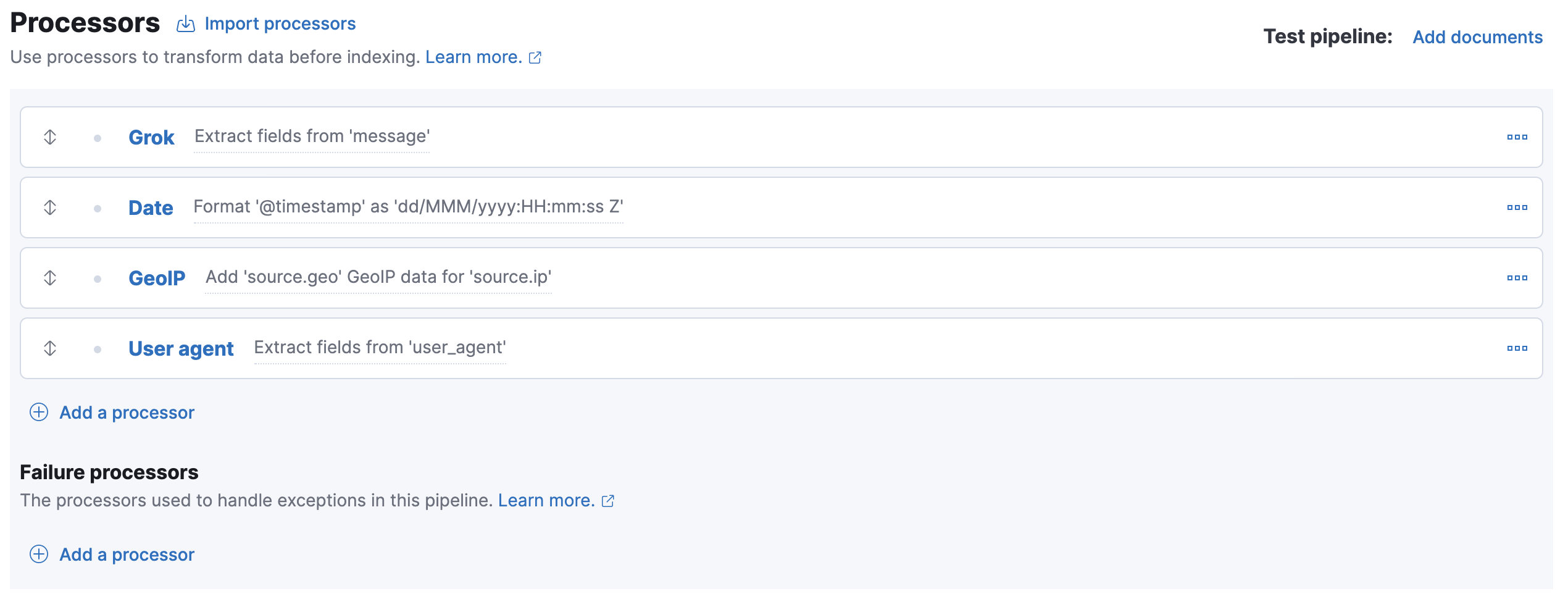

source.geo为 'source.ip' 添加 'source.geo' GeoIP 数据user_agent从 'user_agent' 中提取字段您的表单应类似于以下内容

四个处理器将按顺序运行

Grok > 日期 > GeoIP > 用户代理

您可以使用箭头图标重新排序处理器。或者,您可以单击 导入处理器 链接并将处理器定义为 JSON

{ "processors": [ { "grok": { "description": "Extract fields from 'message'", "field": "message", "patterns": ["%{IPORHOST:source.ip} %{USER:user.id} %{USER:user.name} \\[%{HTTPDATE:@timestamp}\\] \"%{WORD:http.request.method} %{DATA:url.original} HTTP/%{NUMBER:http.version}\" %{NUMBER:http.response.status_code:int} (?:-|%{NUMBER:http.response.body.bytes:int}) %{QS:http.request.referrer} %{QS:user_agent}"] } }, { "date": { "description": "Format '@timestamp' as 'dd/MMM/yyyy:HH:mm:ss Z'", "field": "@timestamp", "formats": [ "dd/MMM/yyyy:HH:mm:ss Z" ] } }, { "geoip": { "description": "Add 'source.geo' GeoIP data for 'source.ip'", "field": "source.ip", "target_field": "source.geo" } }, { "user_agent": { "description": "Extract fields from 'user_agent'", "field": "user_agent" } } ] }

- 要测试管道,请单击 添加文档。

-

在 文档 选项卡中,提供用于测试的示例文档

[ { "_source": { "message": "212.87.37.154 - - [05/May/2099:16:21:15 +0000] \"GET /favicon.ico HTTP/1.1\" 200 3638 \"-\" \"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36\"" } } ]

- 单击 运行管道 并验证管道是否按预期工作。

-

如果一切正常,请关闭面板,然后单击 创建管道。

现在,您可以将日志数据索引到 数据流 中了。

-

resp = client.indices.put_index_template( name="my-data-stream-template", index_patterns=[ "my-data-stream*" ], data_stream={}, priority=500, ) print(resp)

const response = await client.indices.putIndexTemplate({ name: "my-data-stream-template", index_patterns: ["my-data-stream*"], data_stream: {}, priority: 500, }); console.log(response);

PUT _index_template/my-data-stream-template { "index_patterns": [ "my-data-stream*" ], "data_stream": { }, "priority": 500 }

-

使用您创建的管道索引文档。

resp = client.index( index="my-data-stream", pipeline="my-pipeline", document={ "message": "89.160.20.128 - - [05/May/2099:16:21:15 +0000] \"GET /favicon.ico HTTP/1.1\" 200 3638 \"-\" \"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36\"" }, ) print(resp)

const response = await client.index({ index: "my-data-stream", pipeline: "my-pipeline", document: { message: '89.160.20.128 - - [05/May/2099:16:21:15 +0000] "GET /favicon.ico HTTP/1.1" 200 3638 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36"', }, }); console.log(response);

POST my-data-stream/_doc?pipeline=my-pipeline { "message": "89.160.20.128 - - [05/May/2099:16:21:15 +0000] \"GET /favicon.ico HTTP/1.1\" 200 3638 \"-\" \"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36\"" }

-

要验证,请搜索数据流以检索文档。以下搜索使用

filter_path仅返回 文档源。resp = client.search( index="my-data-stream", filter_path="hits.hits._source", ) print(resp)

response = client.search( index: 'my-data-stream', filter_path: 'hits.hits._source' ) puts response

const response = await client.search({ index: "my-data-stream", filter_path: "hits.hits._source", }); console.log(response);

GET my-data-stream/_search?filter_path=hits.hits._source

API 返回

{ "hits": { "hits": [ { "_source": { "@timestamp": "2099-05-05T16:21:15.000Z", "http": { "request": { "referrer": "\"-\"", "method": "GET" }, "response": { "status_code": 200, "body": { "bytes": 3638 } }, "version": "1.1" }, "source": { "ip": "89.160.20.128", "geo": { "continent_name" : "Europe", "country_name" : "Sweden", "country_iso_code" : "SE", "city_name" : "Linköping", "region_iso_code" : "SE-E", "region_name" : "Östergötland County", "location" : { "lon" : 15.6167, "lat" : 58.4167 } } }, "message": "89.160.20.128 - - [05/May/2099:16:21:15 +0000] \"GET /favicon.ico HTTP/1.1\" 200 3638 \"-\" \"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36\"", "url": { "original": "/favicon.ico" }, "user": { "name": "-", "id": "-" }, "user_agent": { "original": "\"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36\"", "os": { "name": "Mac OS X", "version": "10.11.6", "full": "Mac OS X 10.11.6" }, "name": "Chrome", "device": { "name": "Mac" }, "version": "52.0.2743.116" } } } ] } }

Was this helpful?

Thank you for your feedback.