- Elasticsearch 指南其他版本

- 8.17 中的新功能

- Elasticsearch 基础

- 快速入门

- 设置 Elasticsearch

- 升级 Elasticsearch

- 索引模块

- 映射

- 文本分析

- 索引模板

- 数据流

- 摄取管道

- 别名

- 搜索您的数据

- 重新排名

- 查询 DSL

- 聚合

- 地理空间分析

- 连接器

- EQL

- ES|QL

- SQL

- 脚本

- 数据管理

- 自动缩放

- 监视集群

- 汇总或转换数据

- 设置高可用性集群

- 快照和还原

- 保护 Elastic Stack 的安全

- Watcher

- 命令行工具

- elasticsearch-certgen

- elasticsearch-certutil

- elasticsearch-create-enrollment-token

- elasticsearch-croneval

- elasticsearch-keystore

- elasticsearch-node

- elasticsearch-reconfigure-node

- elasticsearch-reset-password

- elasticsearch-saml-metadata

- elasticsearch-service-tokens

- elasticsearch-setup-passwords

- elasticsearch-shard

- elasticsearch-syskeygen

- elasticsearch-users

- 优化

- 故障排除

- 修复常见的集群问题

- 诊断未分配的分片

- 向系统中添加丢失的层

- 允许 Elasticsearch 在系统中分配数据

- 允许 Elasticsearch 分配索引

- 索引将索引分配过滤器与数据层节点角色混合,以在数据层之间移动

- 没有足够的节点来分配所有分片副本

- 单个节点上索引的分片总数已超过

- 每个节点的分片总数已达到

- 故障排除损坏

- 修复磁盘空间不足的数据节点

- 修复磁盘空间不足的主节点

- 修复磁盘空间不足的其他角色节点

- 启动索引生命周期管理

- 启动快照生命周期管理

- 从快照恢复

- 故障排除损坏的存储库

- 解决重复的快照策略失败问题

- 故障排除不稳定的集群

- 故障排除发现

- 故障排除监控

- 故障排除转换

- 故障排除 Watcher

- 故障排除搜索

- 故障排除分片容量健康问题

- 故障排除不平衡的集群

- 捕获诊断信息

- REST API

- API 约定

- 通用选项

- REST API 兼容性

- 自动缩放 API

- 行为分析 API

- 紧凑和对齐文本 (CAT) API

- 集群 API

- 跨集群复制 API

- 连接器 API

- 数据流 API

- 文档 API

- 丰富 API

- EQL API

- ES|QL API

- 功能 API

- Fleet API

- 图表探索 API

- 索引 API

- 别名是否存在

- 别名

- 分析

- 分析索引磁盘使用量

- 清除缓存

- 克隆索引

- 关闭索引

- 创建索引

- 创建或更新别名

- 创建或更新组件模板

- 创建或更新索引模板

- 创建或更新索引模板(旧版)

- 删除组件模板

- 删除悬挂索引

- 删除别名

- 删除索引

- 删除索引模板

- 删除索引模板(旧版)

- 存在

- 字段使用情况统计信息

- 刷新

- 强制合并

- 获取别名

- 获取组件模板

- 获取字段映射

- 获取索引

- 获取索引设置

- 获取索引模板

- 获取索引模板(旧版)

- 获取映射

- 导入悬挂索引

- 索引恢复

- 索引段

- 索引分片存储

- 索引统计信息

- 索引模板是否存在(旧版)

- 列出悬挂索引

- 打开索引

- 刷新

- 解析索引

- 解析集群

- 翻转

- 收缩索引

- 模拟索引

- 模拟模板

- 拆分索引

- 解冻索引

- 更新索引设置

- 更新映射

- 索引生命周期管理 API

- 推理 API

- 信息 API

- 摄取 API

- 许可 API

- Logstash API

- 机器学习 API

- 机器学习异常检测 API

- 机器学习数据帧分析 API

- 机器学习训练模型 API

- 迁移 API

- 节点生命周期 API

- 查询规则 API

- 重新加载搜索分析器 API

- 存储库计量 API

- 汇总 API

- 根 API

- 脚本 API

- 搜索 API

- 搜索应用程序 API

- 可搜索快照 API

- 安全 API

- 身份验证

- 更改密码

- 清除缓存

- 清除角色缓存

- 清除权限缓存

- 清除 API 密钥缓存

- 清除服务帐户令牌缓存

- 创建 API 密钥

- 创建或更新应用程序权限

- 创建或更新角色映射

- 创建或更新角色

- 批量创建或更新角色 API

- 批量删除角色 API

- 创建或更新用户

- 创建服务帐户令牌

- 委托 PKI 身份验证

- 删除应用程序权限

- 删除角色映射

- 删除角色

- 删除服务帐户令牌

- 删除用户

- 禁用用户

- 启用用户

- 注册 Kibana

- 注册节点

- 获取 API 密钥信息

- 获取应用程序权限

- 获取内置权限

- 获取角色映射

- 获取角色

- 查询角色

- 获取服务帐户

- 获取服务帐户凭据

- 获取安全设置

- 获取令牌

- 获取用户权限

- 获取用户

- 授予 API 密钥

- 具有权限

- 使 API 密钥失效

- 使令牌失效

- OpenID Connect 准备身份验证

- OpenID Connect 身份验证

- OpenID Connect 注销

- 查询 API 密钥信息

- 查询用户

- 更新 API 密钥

- 更新安全设置

- 批量更新 API 密钥

- SAML 准备身份验证

- SAML 身份验证

- SAML 注销

- SAML 失效

- SAML 完成注销

- SAML 服务提供商元数据

- SSL 证书

- 激活用户配置文件

- 禁用用户配置文件

- 启用用户配置文件

- 获取用户配置文件

- 建议用户配置文件

- 更新用户配置文件数据

- 具有用户配置文件权限

- 创建跨集群 API 密钥

- 更新跨集群 API 密钥

- 快照和还原 API

- 快照生命周期管理 API

- SQL API

- 同义词 API

- 文本结构 API

- 转换 API

- 使用情况 API

- Watcher API

- 定义

- 迁移指南

- 发行说明

- Elasticsearch 版本 8.17.0

- Elasticsearch 版本 8.16.1

- Elasticsearch 版本 8.16.0

- Elasticsearch 版本 8.15.5

- Elasticsearch 版本 8.15.4

- Elasticsearch 版本 8.15.3

- Elasticsearch 版本 8.15.2

- Elasticsearch 版本 8.15.1

- Elasticsearch 版本 8.15.0

- Elasticsearch 版本 8.14.3

- Elasticsearch 版本 8.14.2

- Elasticsearch 版本 8.14.1

- Elasticsearch 版本 8.14.0

- Elasticsearch 版本 8.13.4

- Elasticsearch 版本 8.13.3

- Elasticsearch 版本 8.13.2

- Elasticsearch 版本 8.13.1

- Elasticsearch 版本 8.13.0

- Elasticsearch 版本 8.12.2

- Elasticsearch 版本 8.12.1

- Elasticsearch 版本 8.12.0

- Elasticsearch 版本 8.11.4

- Elasticsearch 版本 8.11.3

- Elasticsearch 版本 8.11.2

- Elasticsearch 版本 8.11.1

- Elasticsearch 版本 8.11.0

- Elasticsearch 版本 8.10.4

- Elasticsearch 版本 8.10.3

- Elasticsearch 版本 8.10.2

- Elasticsearch 版本 8.10.1

- Elasticsearch 版本 8.10.0

- Elasticsearch 版本 8.9.2

- Elasticsearch 版本 8.9.1

- Elasticsearch 版本 8.9.0

- Elasticsearch 版本 8.8.2

- Elasticsearch 版本 8.8.1

- Elasticsearch 版本 8.8.0

- Elasticsearch 版本 8.7.1

- Elasticsearch 版本 8.7.0

- Elasticsearch 版本 8.6.2

- Elasticsearch 版本 8.6.1

- Elasticsearch 版本 8.6.0

- Elasticsearch 版本 8.5.3

- Elasticsearch 版本 8.5.2

- Elasticsearch 版本 8.5.1

- Elasticsearch 版本 8.5.0

- Elasticsearch 版本 8.4.3

- Elasticsearch 版本 8.4.2

- Elasticsearch 版本 8.4.1

- Elasticsearch 版本 8.4.0

- Elasticsearch 版本 8.3.3

- Elasticsearch 版本 8.3.2

- Elasticsearch 版本 8.3.1

- Elasticsearch 版本 8.3.0

- Elasticsearch 版本 8.2.3

- Elasticsearch 版本 8.2.2

- Elasticsearch 版本 8.2.1

- Elasticsearch 版本 8.2.0

- Elasticsearch 版本 8.1.3

- Elasticsearch 版本 8.1.2

- Elasticsearch 版本 8.1.1

- Elasticsearch 版本 8.1.0

- Elasticsearch 版本 8.0.1

- Elasticsearch 版本 8.0.0

- Elasticsearch 版本 8.0.0-rc2

- Elasticsearch 版本 8.0.0-rc1

- Elasticsearch 版本 8.0.0-beta1

- Elasticsearch 版本 8.0.0-alpha2

- Elasticsearch 版本 8.0.0-alpha1

- 依赖项和版本

随机采样聚合

编辑随机采样聚合

编辑此功能处于技术预览阶段,可能会在未来的版本中更改或删除。Elastic 将努力解决任何问题,但技术预览版的功能不受官方 GA 功能的支持 SLA 约束。

random_sampler 聚合是一种单桶聚合,它随机地将文档包含在聚合结果中。采样以牺牲准确性为代价,提供了显著的速度提升。

采样是通过提供分片中整个文档集合的随机子集来完成的。如果在搜索请求中提供了过滤器查询,则该过滤器将应用于采样的子集。因此,如果过滤器具有限制性,则可能只有很少的文档匹配;因此,统计数据可能不那么准确。

此聚合不要与采样聚合混淆。采样聚合不是对所有文档进行,而是对查询匹配的前 n 个文档进行采样。

resp = client.search( index="kibana_sample_data_ecommerce", size="0", track_total_hits=False, aggregations={ "sampling": { "random_sampler": { "probability": 0.1 }, "aggs": { "price_percentiles": { "percentiles": { "field": "taxful_total_price" } } } } }, ) print(resp)

response = client.search( index: 'kibana_sample_data_ecommerce', size: 0, track_total_hits: false, body: { aggregations: { sampling: { random_sampler: { probability: 0.1 }, aggregations: { price_percentiles: { percentiles: { field: 'taxful_total_price' } } } } } } ) puts response

const response = await client.search({ index: "kibana_sample_data_ecommerce", size: 0, track_total_hits: "false", aggregations: { sampling: { random_sampler: { probability: 0.1, }, aggs: { price_percentiles: { percentiles: { field: "taxful_total_price", }, }, }, }, }, }); console.log(response);

GET kibana_sample_data_ecommerce/_search?size=0&track_total_hits=false { "aggregations": { "sampling": { "random_sampler": { "probability": 0.1 }, "aggs": { "price_percentiles": { "percentiles": { "field": "taxful_total_price" } } } } } }

random_sampler 的顶层参数

编辑-

probability - (必需,浮点数)文档包含在聚合数据中的概率。必须大于 0,小于

0.5,或正好为1。概率越低,匹配的文档就越少。 -

seed - (可选,整数)生成文档随机采样的种子。当提供种子时,文档的随机子集在调用之间是相同的。

采样如何工作?

编辑聚合是索引中所有文档的随机样本。换句话说,采样是对后台文档集进行的。如果提供了查询,则当文档与查询匹配且该文档在随机采样中时,会返回该文档。采样不是在匹配的文档上进行的。

考虑文档集合 [1, 2, 3, 4, 5]。您的查询匹配 [1, 3, 5],并且随机采样的集合是 [2, 4, 5]。在这种情况下,返回的文档将是 [5]。

这种类型的采样在查询延迟方面提供了几乎线性的改进,这与采样减少文档集的大小有关

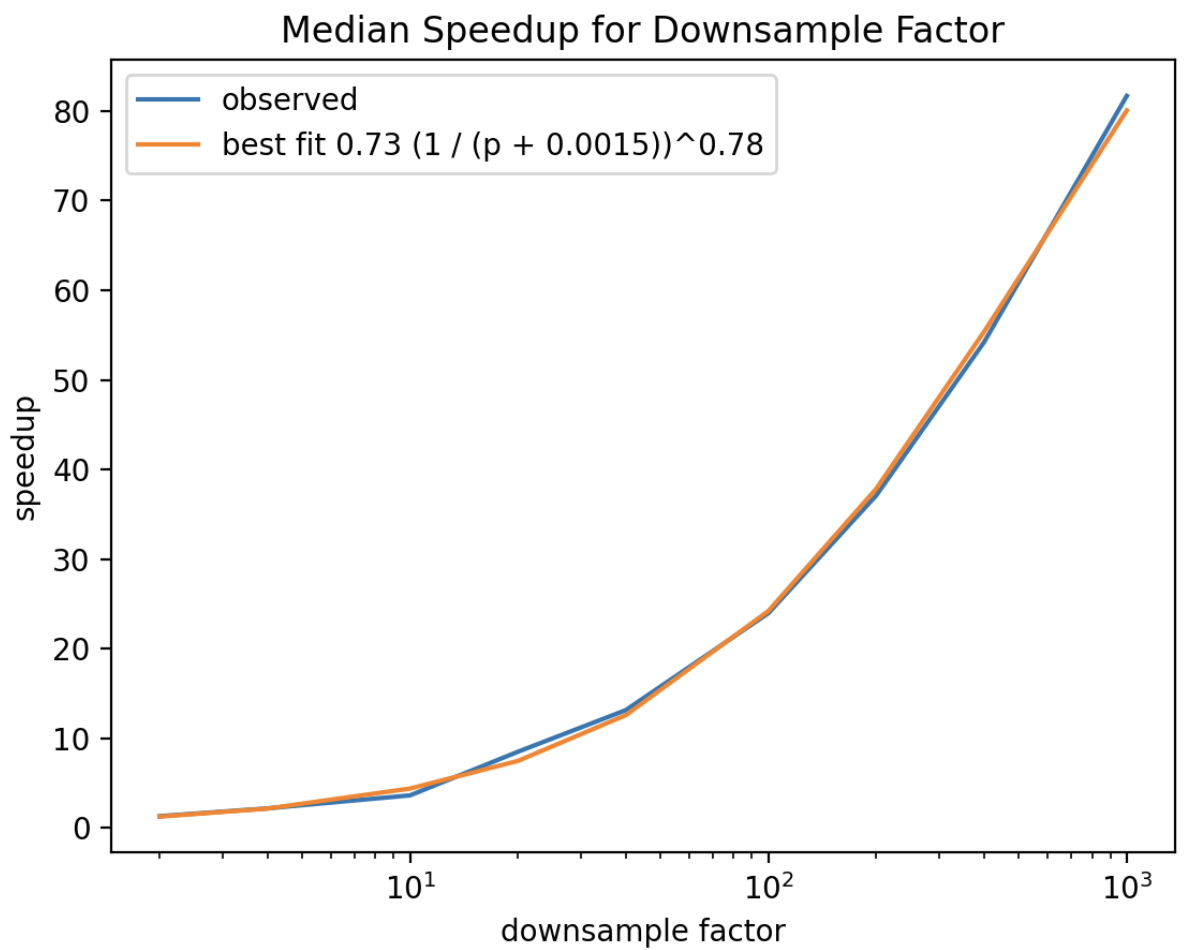

此图是针对 6300 万个文档的测试数据集的大多数聚合加速的典型情况。确切的常量将取决于数据集的大小和分片的数量,但是加速与概率之间的关系形式广泛成立。对于某些聚合,加速可能不那么明显。这些聚合具有一些与所见文档数量无关的恒定开销。即使对于这些聚合,速度的提高也可能是显著的。

样本集是通过使用几何分布 ((1-p)^(k-1)*p) 跳过文档生成的,成功概率是提供的 probability(分布方程中的 p)。从分布返回的值指示在后台跳过多少个文档。这等效于均匀随机地选择文档。由此可见,成功前的预期失败次数为 (1-p)/p。例如,当 "probability": 0.01 时,预期失败次数(或跳过的文档平均数)将为 99,方差为 9900。因此,如果您的索引中只有 80 个文档或您的过滤器匹配 80 个文档,则很可能不会收到任何结果。

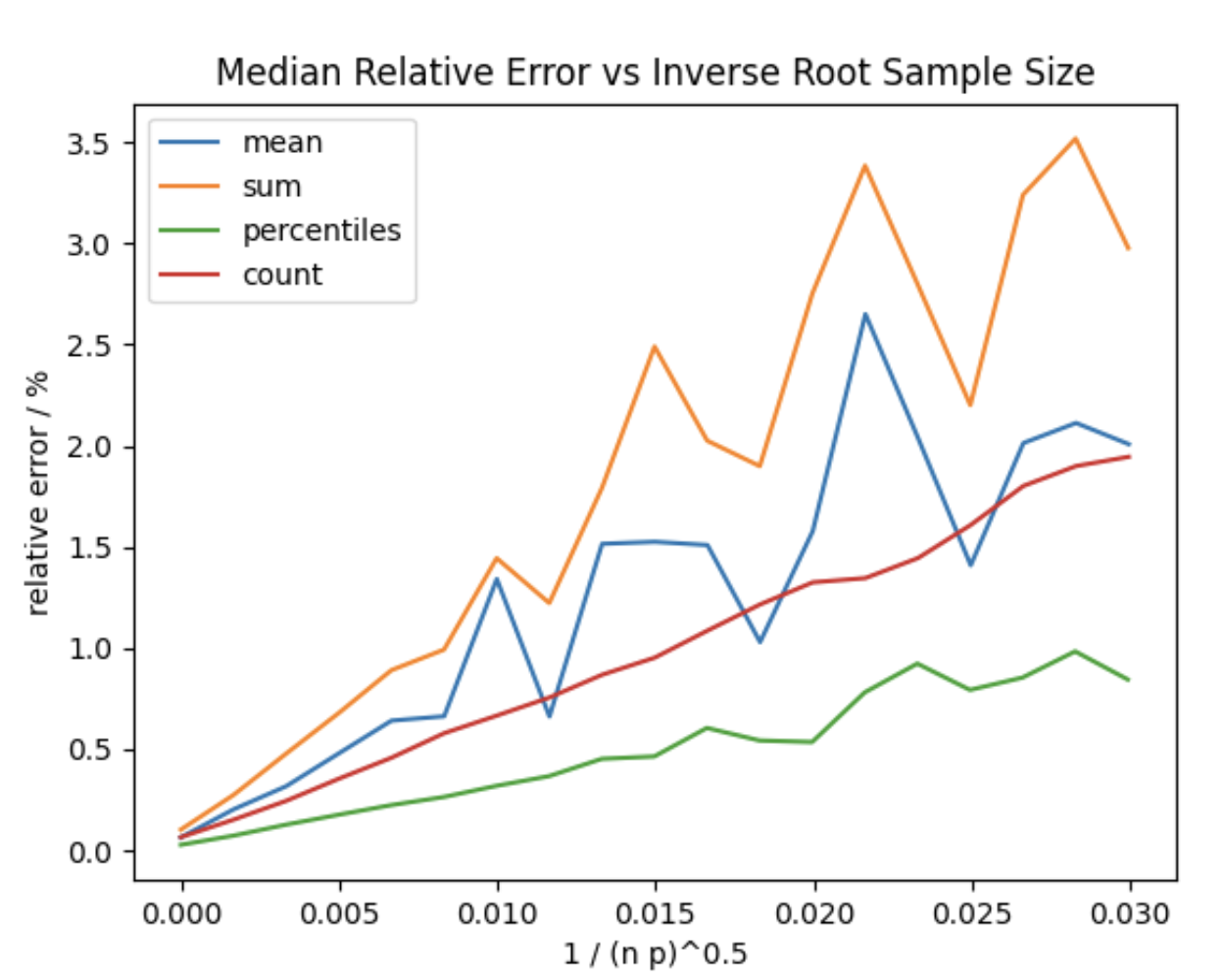

在上图中,p 是提供给聚合的概率,n 是任何提供的查询匹配的文档数量。您可以看到离群值对 sum 和 mean 的影响,但是当在较高的采样率下仍然匹配许多文档时,相对误差仍然很低。

这表示针对典型的正偏斜 APM 数据集(该数据集在上限尾部也有离群值)进行聚合的结果。发现相对误差对样本大小的线性依赖性广泛成立,但斜率取决于被聚合的数量的变化。因此,您自己数据中的方差可能会导致相对误差率以不同的速率增加或减少。

随机采样器一致性

编辑对于给定的 probability 和 seed,当从同一分片中采样未更改的数据时,随机采样器聚合是一致的。但是,这是后台随机采样,特定文档是否包含在采样集中取决于当前段的数量。

这意味着,副本分片与主分片可能会返回不同的值,因为会采样不同的特定文档。

如果通过添加、更新、删除或段合并更改了分片,则采样的特定文档可能会更改,从而导致生成的统计数据发生更改。

从随机采样器聚合使用的生成的统计数据是近似的,应该被这样对待。

随机采样特殊情况

编辑随机采样器聚合返回的所有计数都经过缩放,以方便可视化和计算。例如,当随机采样日期直方图聚合时,每个桶的每个 doc_count 值都按 random_sampler probability 值的倒数进行缩放。因此,如果桶的 doc_count 为 10,000,而 probability: 0.1,则聚合的实际文档数为 1,000。

对此的一个例外是基数聚合。唯一项计数不适合自动缩放。在解释基数计数时,请将其与 random_sampler 聚合中顶层提供的 doc_count 中提供的采样文档数进行比较。它可以让您了解唯一值占总值的百分比。但是,它可能无法反映给定字段的唯一值的确切数量。

On this page